Google AIO : le passage de SGE aux AI Overviews

Code rouge chez Google

Dans l’article précédent, on a vu comment Google est passé d’un état d’alerte interne à l’arrivée de Bard, puis de Gemini, avant de proposer un premier aperçu de sa nouvelle SERP alimentée par l’intelligence artificielle, appelée SGE : Search Generative Experience qui marque le commencement de Google AI Overviews.

Dans cet article, on va essayer de décrypter ce qu’est Google AI Overviews, plus communément appelé Google AIO du point de vue technique, et surtout, souligner ce que Google nous dévoile sur cette technologie.

Sans plus tarder, plongeons directement dans le cœur du sujet.

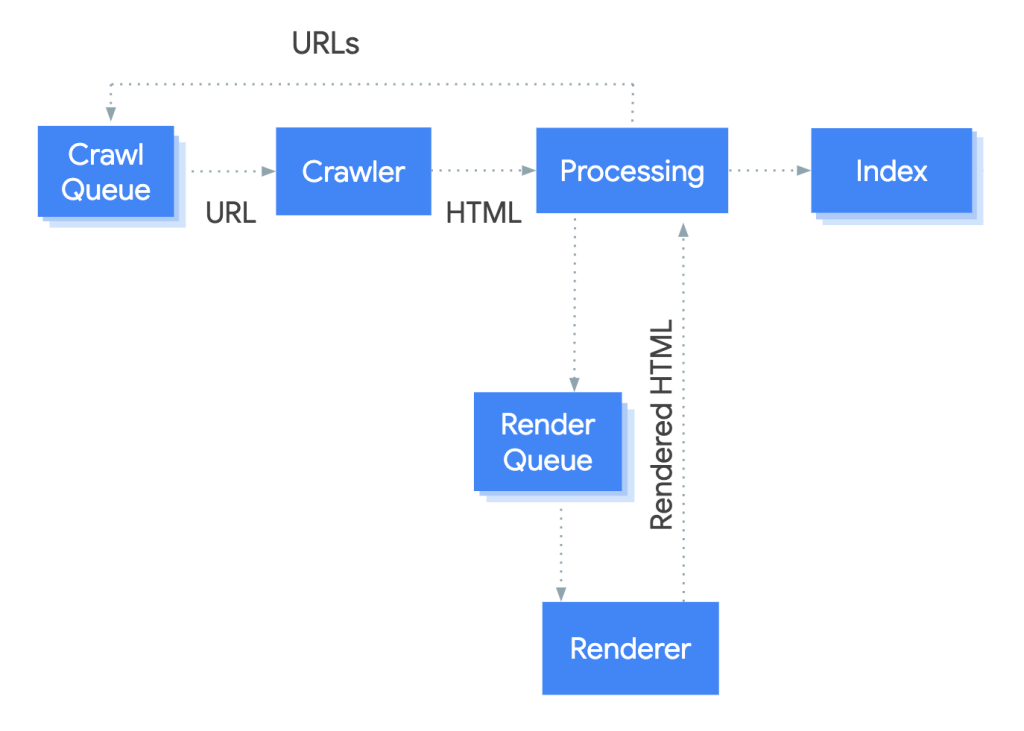

Les étapes de la recherche Google : crawl, index, rank

Avec AI Overviews, Google réinvente une fois de plus la page de résultats. L’utilisateur pose une question… et la réponse tombe. Directe. Résumée. Claire.

Pour y arriver, Google nous dit qu’ils ont injecté l’intelligence artificielle au cœur du processus traditionnel.

Mais pour bien saisir comment l’IA s’intègre, commençons par jeter un œil au processus classique de l’algorithme de Google. Avant de figurer dans les résultats de recherche, une page web passe par trois étapes : crawl, index, rank.

Si vous n’êtes pas anglophones, vous êtes un peu dans le pétrin. Vous allez devoir vous mettre sérieusement à l’anglais…

Non, je rigole. Mais franchement, apprenez l’anglais, ça peut jamais faire de mal.

Bref, revenons à nos moutons.

Google explique très bien ces étapes sur sa page officielle. On parle d’exploration, d’indexation, et de diffusion.

- Exploration, Google découvre votre site via ses robots (les fameux crawlers) qui n’arrêtent jamais d’explorer le web. Et là, Google télécharge vos textes, images, vidéos… tout ce qui peut l’aider à capter ce que vous racontez sur votre site.

- Indexation : Google analyse le texte, les images et les fichiers vidéo sur la page, puis stocke toutes ces informations dans son index, une énorme base de données.

- Diffusion des résultats de recherche : quand un internaute fait une recherche, Google affiche les résultats les plus pertinents en fonction de la requête.

Le rendering : l’autre étape de la recherche Google

Je vous ai parlé des trois étapes de la recherche Google.

Mais vous êtes observateurs. Vous avez remarqué que le schéma en haut montre plus que trois étapes. Et vous avez raison. Ni vous, ni moi ne sommes dans l’erreur.

En réalité, il existe une quatrième étape : le rendering. Et là, je vais être honnête… je ne saurais même pas vraiment vous donner une vraie traduction en français. Même Google utilise le terme tel quel. C’est resté en anglais, partout.

Le rendering, c’est un peu comme si Google prenait une pause pour « voir » la page comme vous et moi. Pas juste lire le code brut, mais vraiment l’afficher. Cette étape concerne essentiellement les sites qui utilisent Javascript.

Comme la grande majorité des sites utilisent du JavaScript aujourd’hui — que ce soit pour charger du contenu, animer des éléments ou même afficher du texte — on peut dire que cette étape de rendering est, de facto, devenue incontournable.

Donc, avant même de penser SGE, IA, ou AIO, Google commence par là : découvrir, comprendre, organiser.

Maintenant qu’on a les bases, on peut enfin se poser la vraie question :Où est-ce que l’intelligence artificielle vient se greffer dans tout ça ?

Intrégration de l’IA dans la recherche Google

Sur l’image précédente, on observait le fonctionnement de Google avant l’arrivée de l’IA.

Un processus assez classique, presque mécanique : un robot qui explore, traite, « rend » puis indexe. Tout ça pour faire entrer les pages d’un site dans l’index de Google, afin de les proposer ensuite dans les résultats.

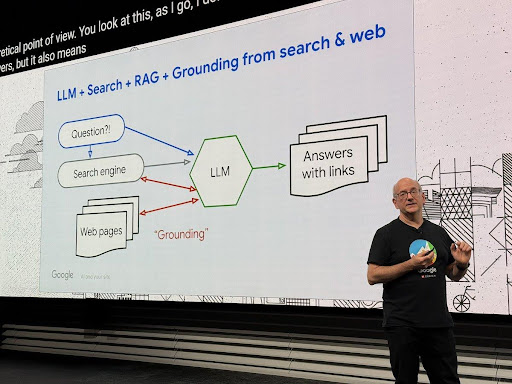

Et puis, il y a cette nouvelle image. prise par Aleyda Solis lors d’un meet Google et SEO a Madrid qui montre l’évolution du processus de recherche.

Ici, tout commence par une question posée par l’utilisateur. Et là, changement de paradigme : c’est un LLM (Large Language Model) qui prend le relais. Il ne se contente pas de chercher une page. Il cherche une réponse.

Ce modèle ne se limite pas à la requête en cours. Il va plus loin : il anticipe les questions que l’utilisateur pourrait poser ensuite. C’est ce que Google appelle des résumés prédictifs.

Résultat : la réponse générée par l’IA contient non seulement ce que vous avez demandé… mais aussi ce que vous alliez probablement chercher juste après.

En l’occurence, le moteur de recherche classique fait son travail. Comme si de rien n’était..

Ce qui est interessant ici, c’est le fait que le LLM de Google cherche une réponse dans sa base de donnée. Pas sur l’index google (les sites indexés). Gardez ça en tete, c’est un detail de taille…

Puis, vient l’ancrage — ou grounding, pour ceux qui aiment l’anglais technique. C’est là que l’IA de Google va revérifier sa copie, en allant chercher les sources les plus pertinentes dans son index.

Dit simplement : dans le SEO “classique”, Google part d’une page web, puis s’en sert pour construire une réponse.

Avec AI Overviews, le raisonnement est inversé. Google génère d’abord une réponse grâce à son modèle, puis va chercher des sources pour la justifier après coup.

Cette approche pose problème. Rien n’empêche le LLM d’halluciner et cueillir dans l’index de google une source qui valide la fausse réponse.

Dejan, un SEO de renommé, a été un des premier de signaler l’inefficacité de cette démarche dans un article qu’il nomme Je pense que Google s’est trompé en adoptant l’approche « Generate → Ground ».

Je cite : ‘ Franchement, d’un point de vue efficacité, je pense que Google s’est un peu pris les pieds dans le tapis avec cette logique du Generate → Ground.

Pourquoi ? Parce que tout repose sur ce que génère le modèle en premier. On commence par une réponse autorégressive— donc une réponse prédite mot après mot, comme une suite logique — et on essaie de la rattraper après, en la collant à des sources.

Sauf que si le modèle se plante dès le départ… ben c’est toute la réponse qui tombe à côté de la plaque. Le groundingdevient une rustine, pas un socle.

Une séquence plus logique ? Ce serait de commencer par les sources, de construire la réponse à partir d’elles, et de s’appuyer dessus du début à la fin.

Mais là, on a un pipeline qui met la charrue avant les bœufs — et ça, c’est risqué.’